El “Conozca a su Cliente” moderno Los sistemas “Conozca a su Cliente” modernos, KYC (Know Your Customer), aprovechan tecnologías avanzadas para permitir la incorporación remota de clientes. En el proceso, el usuario suele presentar un documento de identificación y luego se toma un selfie. Luego, algoritmos sofisticados verifican la foto del documento de identificación con la selfie para autenticar la identidad del usuario. Este método ha agilizado el proceso KYC, lo que permite a las empresas incorporar clientes de forma remota sin sacrificar la integridad y la seguridad de sus sistemas

Sin embargo, los ataques de presentación son una forma común que utilizan los estafadores para manipular este proceso. Estos ataques consisten en presentar un objeto falsificado o manipulado, u otro medio a un sensor biométrico. En el caso de los sistemas KYC remotos, esto puede implicar el uso de una foto o un vídeo en lugar de un selfie en directo. Este tipo de fraude ha sido ampliamente explotado, lo que ha impulsado el desarrollo de nuevos estándares como ISO/IEC 30107.

This standard provides methods for testing the ability of biometric technology to resist presentation attacks, and even provides certification with levels 1-2 from organizations like Este estándar proporciona métodos para probar la habilidad de la tecnología biométrica para resistir ataques de presentación, e incluso provee certificación de nivel 1-2 de organizaciones como Laboratorio de garantía de calidad iBeta. Dichas certificaciones validan que una solución particular para los ataques de presentación,.

Such certification validates that a particular Presentation Attack Detection (PAD), proporciona el nivel de protección necesario contra ataques de presentación.

A pesar de estas medidas de protección, la industria de la identidad digital se enfrenta ahora a un nuevo tipo de ataque denominado ataque de inyección. En este escenario, no se presenta una imagen o un vídeo a la cámara, sino que se inyecta mediante una cámara virtual, una memoria USB de hardware o incluso un código JavaScript que secuestra la transmisión de vídeo de la cámara. La siguiente imagen demuestra cómo se podría utilizar un capturador USB externo para la inyección.

Para el sistema operativo, un capturador USB estándar aparece como una cámara USB normal. Sin embargo, la transmisión de vídeo no se origina en la lente de una cámara, sino en la pantalla de una computadora portátil que actúa como fuente, y se refleja y captura mediante el dispositivo USB. Esto se puede lograr con una simple función de extensión de pantalla que se activa conectando un cable USB-C a una computadora portátil. Al abrir cualquier foto/video en la pantalla de la computadora portátil de origen, éste se transmitirá como un video que supuestamente proviene de la cámara USB. Tanto el sistema operativo como la aplicación que se ejecuta en la computadora portátil receptora no pueden reconocer que la transmisión de video no proviene de la lente de una cámara, lo que lo convierte en un truco de bajo costo pero efectivo para los estafadores.

¿Cómo se puede detectar y prevenir este tipo de inyección?

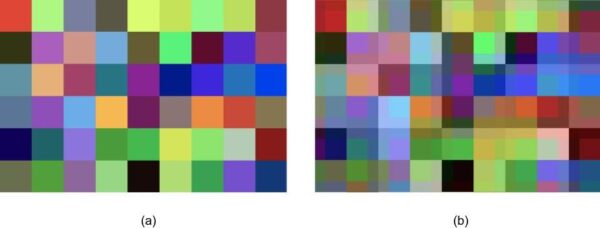

Aquí es donde entra en juego la Inteligencia Artificial (IA). Curiosamente, el flujo de vídeo que pasa desde la pantalla a través del capturador USB se comprime dos veces. En primer lugar, esto ocurre cuando la señal de vídeo original se archiva en el disco duro de la computadora portátil de origen. Posteriormente, a pesar de la alta resolución del formato de vídeo original, éste presenta artefactos debido a la recompresión cuando se transfiere a través del capturador USB. Estos artefactos son un subproducto de los algoritmos de compresión que buscan minimizar el tamaño de los datos de video o convertirlos de un formato a otro, lo que a menudo resulta en una pérdida de detalles de la imagen. Estas alteraciones pueden manifestarse como imágenes borrosas o en bloques, bandas de color o efectos de manchas.

Figura. Se escaló una pequeña área de la imagen original. (a) y recomprimido (b).

Estos artefactos suelen ser invisibles para el ojo humano, pero pueden ser detectados por una IA específicamente entrenada para este propósito. Así como una red neuronal puede ser entrenada para reconocer objetos, rostros y ataques de presentación, también puede distinguir entre imágenes provenientes de una cámara real y aquellas inyectadas a través de un capturador USB o una cámara virtual. Estos métodos de inyección generalmente implican procesos más complejos y, por lo tanto, generan más pérdidas durante la transmisión de la señal de video, lo que proporciona una base para la detección.

Entrenar una red neuronal artificial para realizar esta tarea normalmente requiere un volumen significativo de muestras. Por ejemplo, entre 10.000 y 100.000 muestras podrían ser suficientes para entrenar un producto mínimo viable (MVP) de una red neuronal basada en capas convolucionales. Para un detector más preciso y robusto, podrían necesitarse entre 100.000 y 1 millón de muestras. Para aplicaciones comerciales que exigen alta precisión, podrían requerirse hasta 1 millón de muestras.

Al invertir en este tipo de soluciones de IA , los procesos de verificación de identidad digital pueden combatir mejor la creciente amenaza de ataques de inyección, mejorando la seguridad general de la incorporación remota y otros procesos de identificación digital.