Metodologias para o Desenvolvimento de Algoritmos em Apoio aos Princípios da IA Responsável

O uso crescente da biometria levou à necessidade de uma precisão consistente entre raças, idades e gêneros. Onde há parcialidade, há o potencial para os indivíduos terem experiências diferentes com base na sua aparência. Por exemplo, um indivíduo pode ter mais dificuldade em utilizar a sua biometria para autenticar, ou estar sujeito a uma maior suspeita de fraude.

O enviesamento não se limita a algoritmos de comparação biométrica. Também se aplica à detecção de ataques de apresentação (“PAD”)[1] , que é essencial quando o reconhecimento facial é utilizado para processos de segurança não supervisionados, tais como o onboarding digital, login no mobile, e controle de acesso físico.

Este artigo apresenta um white paper que explora metodologias que a ID R&D tem empregado para mitigar o enviesamento nos algoritmos de PAD facial em apoio aos princípios da IA Responsável.

[1] https://www.iso.org/standard/53227.html

Definição de viés para detecção de ataques de apresentação

A parcialidade na IA podem ser causados por desequilíbrios nos dados de treinamento, ou pelos erros no desenvolvimento de algoritmos como resultado de preconceitos humanos e falsas suposições. No treinamento, os enviesamentos podem resultar da subrepresentação de certos dados demográficos, bem como da utilização de dados de decisão de classificação tendenciosa.

A primeira pergunta a responder relacionada com um sistema de liveness é “qual é a natureza do preconceito num sistema de detecção de ataques de apresentação”. Erros de falso-positivos criam inconvenientes para os clientes, e é aqui que pode ocorrer a parcialidade nos sistemas PAD. Por exemplo, se o sistema causar falsos positivos para os Negros a um ritmo mais elevado do que para os Brancos, ou para os homens a um ritmo mais elevado do que para as mulheres, então isto é uma prova de enviesamento demográfico nos sistemas de PAD. Estes erros de falso-positivos contribuem para a Taxa de Erros de Classificação de Apresentação Bona Fide (“BPCER”). Para que um sistema seja considerado imparcial, o sistema PAD deve 1) ser estatisticamente igual entre os dados demográficos e 2) deve ter um BPCER baixo.

Metodologias para a atenuação do viés

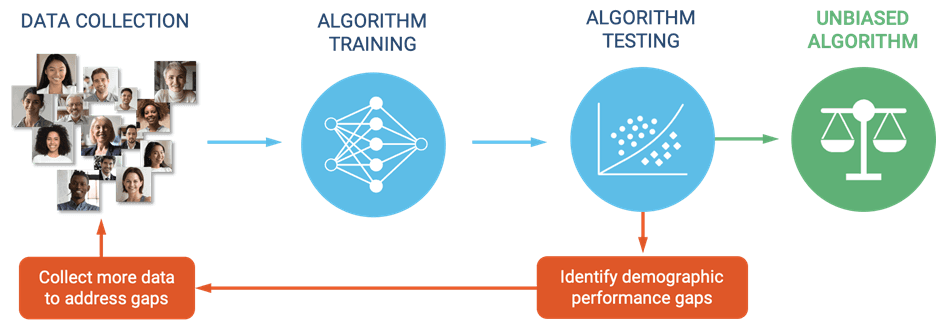

A fim de mitigar o enviesamento de IA nos algoritmos de liveness facial, a ID R&D analisa dados demográficos para identificar potenciais lacunas no desempenho e conduzir a melhorias contínuas dos algoritmos. As variáveis demográficas são optimizadas para o sexo, idade, e raça. Os subfactores adicionais que têm impacto nestes grupos também são acompanhados. Um exemplo é o das pessoas que usam hijabs, que está altamente correlacionado com o gênero e a etnia e também afeta directamente o desempenho do sistema de liveness facial.

Figura 1. Desenvolvimento de algoritmos com foco na atenuação de vieses

Exemplos de Redução de Viés

A equipe realizou uma série de ações para combater o viés e continua a aplicar métodos para alcançar a equidade entre os grupos demográficos. Seguem dois exemplos:

Exemplo 1 – BPCER menor em categorias subrepresentadas

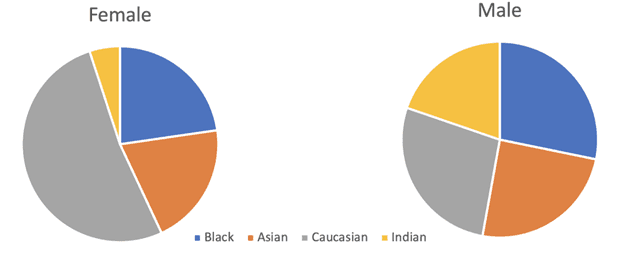

A ID R&D conduziu uma análise detalhada das categorias com desempenho inferior. Para a categoria de raça, os cientistas de dados analisaram os grupos negros, asiáticos, caucasianos e indianos.

Figura 2. Distribuição por raça e sexo.

Conhecendo a distribuição, podem ser tiradas as seguintes conclusões:

- É necessário recolher mais dados para as categorias sub-representadas

- Durante o treinamento, o foco deve ser colocado nas categorias menos representadas

- Ao avaliar a qualidade do algoritmo, vale a pena escolher um modelo que funcione igualmente bem em todas as categorias

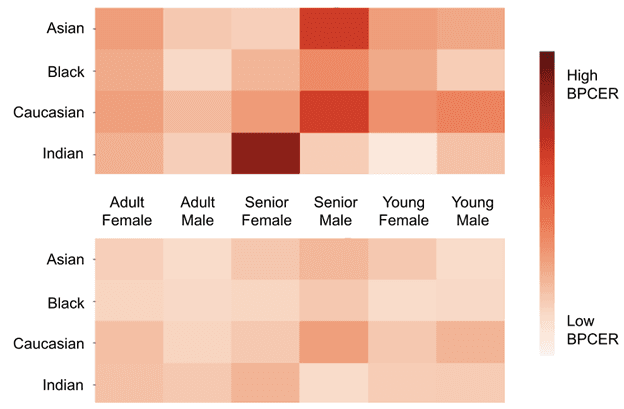

Figura 3. Mapa de calor BPCER antes e depois da aplicação de mais dados para categorias de dados pobres e amostragem ponderada durante o treinamento.

Exemplo 2 – BPCER menor para características da Sub-Categoria

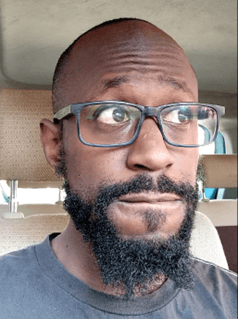

A ID R&D conduziu uma análise detalhada das condições em que o desempenho foi fraco. Para as categorias em que os algoritmos tiveram um mau desempenho, as equipas analisaram as imagens no conjunto de dados para determinar as áreas da imagem consideradas “importantes” ao fazer a sua previsão. Este método ajuda a determinar áreas discriminatórias na imagem.

(a)

(b)

(c)

(d)

Figura 4. Os mapas de calor da rede neural demonstram a área de interesse do algoritmo de liveness facial: a) imagem original de uma mulher com lenço na cabeça b) o mapa de calor da rede neural tem maior atenção nas partes média e inferior do lenço, c) imagem original de um homem de bigode e barba, d) mapa de calor da rede neural tem atenção na parte inferior do rosto, bem como na parte da barba perto da orelha.

Desempenho tendencioso – Relatório de teste

De acordo com a definição de enviesamento da ID R&D, o objetivo final é operacionalizar metodologias de desenvolvimento de software em apoio aos princípios da IA Responsável para atingir o mais próximo possível de 0% de BPCER através da idade, raça, e género.

Em apoio a este objetivo, a ID R&D encomendou a primeira avaliação independente de enviesamento na detecção de liveness facial. Bixelab, um laboratório biométrico independente e acreditado, realizou uma avaliação exaustiva da tecnologia de detecção de liveness facial da ID R&D para o enviesamento da demografia alvo, incluindo idade, sexo, e raça/etnia.

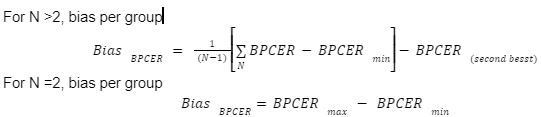

Foi utilizada a seguinte metodologia de cálculo de erros:

Onde N é o número total de atributos de um grupo demográfico. Por exemplo, os atributos do grupo Raça são caucasianos, africanos, asiáticos orientais e sul-asiáticos.

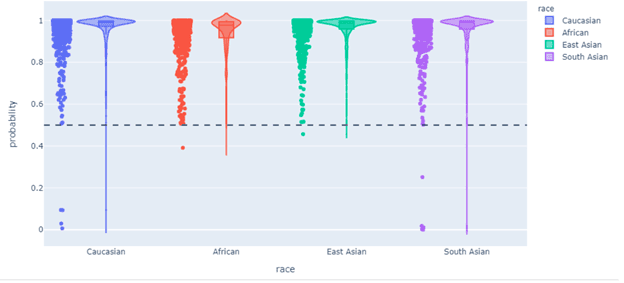

Os resultados da avaliação demonstram que o software funciona com níveis de enviesamento abaixo dos valores-alvo críticos. Estes estão ilustrados na tabela seguinte. O relatório completo com todos os detalhes do teste está disponível na ID R&D.

Tabela: Resumo da variação de desempenho medida para cada grupo demográfico e decisões tendenciosas correspondentes

| Grupo | Métrica de enviesamento | Valor Crítico (nível de 95%

de confiança) |

Hipótese Nula

Aceitar: Métria de Viès <Valor Crítico Rejeitar: Métrica de Viés >Valor Crítico |

Enviesamento:

Não tendencioso se a Hipótese Nula for aceita Parciais se Nulo A hipotese é rejeitada |

| Idade | 0.0008 | 0.002 | Aceita | Sem viés |

| Género | 0.002 | 0.004 | Aceita | Sem viés |

| Raça/etinia | 0.0025 | 0.0031 | Aceita | Sem viés |

Gráfico: Representação em violino ilustra a probabilidade de falsa rejeição para diferentes raças

Conclusão

O viés deve ser ativamente tratado tanto para os comparadores biométricos como para a detecção de ataques de apresentação. O viés é particularmente destacado para a biometria facial. Os princípios da IA responsável guiam a utilização de metodologias para remover o viés. A validação por terceiros independentes prova que a aplicação destes princípios resulta num sistema de Detecção de Ataques de Apresentação justo e geralmente livre de vieses.

As redes neurais da ID R&D foram treinadas em quantidades extremamente grandes de dados. Ao assegurar uma representação adequada de todos os dados demográficos, os algoritmos de PAD da ID R&D podem ter um desempenho quase igual em todas as raças e gêneros. O trabalho futuro continuará a aplicar estas técnicas no sentido de reduzir o enviesamento e de fazer descer a BPCER em todos os aspectos demográficos. O trabalho continuará a aderir a metodologias que apoiam os princípios da IA Responsável.

O whitepaper completo pode ser encontrado aqui. Saiba mais sobre a tecnologia e os produtos de liveness facial passivo da ID R&D.